카카오, 최고 성능 경량 멀티모달 언어모델 오픈소스 공개

자체 모델 개발 역량 및 서비스 운영 경험 바탕 ‘독자 AI 파운데이션 모델 프로젝트’ 참여

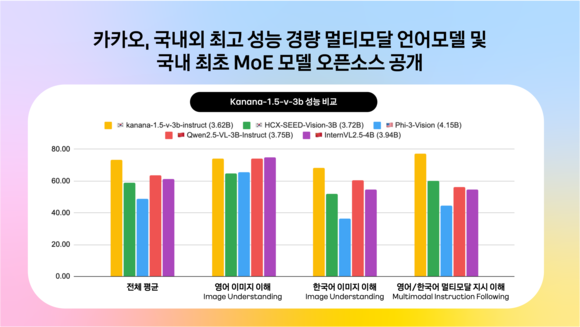

▲카나나-v와 국내외 모델 비교 / 자료=카카오

카카오(대표 정신아)는 24일 허깅페이스를 통해 이미지 정보 이해 및 지시 이행 능력을 갖춘 경량 멀티모달 언어모델 ‘Kanana-1.5-v-3b’와 MoE(Mixture of Experts) 언어모델 ‘Kanana-1.5-15.7b-a3b’를 오픈소스로 공개했다고 밝혔다.

지난 5월 공개한 언어모델 Kanana-1.5 4종에 이어 두 달 만에 추가 모델을 오픈소스로 공개하며, 독자적 모델 설계 기반의 기술 경쟁력을 증명했다. 정부가 추진하는 ‘독자 AI 파운데이션 모델 프로젝트’에 참여한 카카오는 이러한 자체 모델 개발 역량 및 카카오톡 등의 대규모 서비스 운영 경험 등을 토대로 전 국민의 AI 접근성을 높이고, 국가 AI 경쟁력을 강화하는 데 기여할 방침이다.

Kanana-1.5-v-3b는 텍스트뿐 아니라 이미지 정보도 처리할 수 있는 멀티모달 언어모델로, 지난 5월 말 오픈소스로 공개한 Kanana 1.5 모델을 기반으로 하고 있다. Kanana 1.5는 모델 개발의 처음부터 마지막 단계까지 카카오의 자체 기술을 바탕으로 구축하는 ‘프롬 스크래치(From Scratch)’ 방식으로 개발됐다.

멀티모달 언어모델인 Kanana-1.5-v-3b는 이용자의 질문 의도를 정확히 이해하는 높은 지시 이행(instruction following) 성능과 뛰어난 한국어·영어 이미지 이해 능력을 보유한 것이 특징이다. 경량 모델임에도 이미지로 표현된 한국어와 영어 문서 이해 능력이 글로벌 멀티모달 언어모델 GPT-4o와 견줄 수 있을 정도로 뛰어나다.

Kanana-1.5-v-3b는 경량 멀티모달 언어모델의 강점을 토대로 ▲이미지 및 글자 인식 ▲동화 및 시 창작 ▲국내 문화유산 및 관광지 인식 ▲도표 이해 ▲수학 문제풀이 등 여러 분야에서 유연하게 활용할 수 있다.

카카오는 이날 일반적인 ‘밀집(Dense)’ 모델과 차별화되는 MoE 구조의 언어모델을 오픈소스로 함께 공개했다.

MoE는 입력 데이터 처리 시 모든 파라미터가 연산에 참여하는 기존 모델과 달리 특정 작업에 최적화된 일부 전문가 모델만 활성화되는 방식이다. 효율적인 컴퓨팅 자원 활용과 비용 절감이 강점이다.

MoE 아키텍처를 적용한 Kanana-1.5-15.7b-a3b는 전체 15.7B의 파라미터 중 추론 시 약 3B 파라미터만 활성화돼 동작한다. 카카오는 모델의 학습 시간과 비용을 절약하기 위해 자사의 3B 규모의 모델 ‘Kanana-Nano-1.5-3B’에 ‘업사이클링(Upcycling)’ 방식을 적용해 개발했다. 활성화되는 파라미터가 3B에 불과하지만, 성능은 ‘Kanana-1.5-8B’와 동등하거나 상회하는 수준을 기록했다.

카카오의 MoE 모델은 고성능 AI 인프라를 저비용으로 구축하고자 하는 기업이나 연구 개발자들에게 실용적인 도움을 제공할 수 있다. 특히 추론 과정에서 제한된 파라미터만 사용하는 구조적 특성 덕분에 저비용, 고효율 서비스 구현에 유리해 활용도가 높다.

김병학 카카오 카나나 성과리더는 “이번 오픈소스 공개는 비용 효율성과 성능이라는 유의미한 기술 개발의 성과를 거둔 것으로, 단순한 모델 아키텍처의 진보를 넘어 서비스 적용과 기술 자립이라는 두 가지 측면의 목표에 부합하는 결과물”이라고 말했다.

강동식 기자 lavita@datanews.co.kr

[ⓒ데이터저널리즘의 중심 데이터뉴스 - 무단전재 & 재배포 금지]